Vous les avez peut-être vu passer, ces covers improbables réalisées via un modèle d'IA... le streameur Antoine Daniel qui reprend Renaud, ou Kurt Cobain qui reprend Don't look back in anger d'Oasis... grâce au voice-cloning, il est possible de créer un modèle autonome d'imitation de voix, et de plaquer cette voix sur n'importe quel enregistrement audio d'une autre voix, qu'il s'agisse de chant ou de discours. Cela vous a sans doute amusé, un peu fasciné aussi, et peut-être avez-vous été poussé par la curiosité, à vous demander comment faire pareil chez vous, avec vos propres modèles. Derrière ces sons, souvent, la technologie d'IA RVC. Mais peut-on reproduire ça chez soi ?

Étonnamment, non seulement c'est possible, mais il n'est pas besoin d'une machine de guerre ou de connaissances ultra-poussées pour y parvenir. Avec Applio, qui reprend la technologie RVC2, il est très facile de faire vos propres modèles... et vos propres AI covers. Voyons comment on s'y prend, vous allez voir, c'est rien de sorcier ! Il vous faudra juste disposer d'un PC suffisamment performant, de quelques compétences très basiques en manipulation de fichier audio, et d'un peu de patience.

Vous avez tout ça en stock ? Alors c'est parti, on s'y met !

Les prérequis

Du son pour nourrir le modèle

Ce n'est rien de sorcier, mais il va quand-même falloir préparer un peu le terrain. Vous aurez besoin des éléments suivants :

En premier lieu, pour entraîner le modèle, il faut lui donner à manger. En l'occurrence, la voix que vous voulez copier. Il vous faudra donc des enregistrements de bonne qualité. Attention, cette voix doit être "pure", c'est-à-dire dépourvue de bruit de fond, de musique, d'interruptions par d'autres voix, etc. Plus vous lui donnerez un fichier audio long, avec une voix parfaitement isolée de tout autre son parasite, plus le résultat sera de qualité. Si les fichiers dont vous disposez sont pollués par d'autres voix (par exemple lors d'une interview), vous pouvez utiliser Audacity pour ne garder que les sections intéressantes.

Si vous souhaitez imiter la voix d'un chanteur, il faudra donc d'abord l'isoler de la musique. Vous pouvez pour ce faire utiliser UVR5 en suivant notre tutoriel pour générer des versions acapella ou encore passer par MVSEP dont on parlait dans notre article sur les 10 services d'IA en ligne à connaître.

Si vous souhaitez utiliser votre propre voix, histoire que vos karaokés soient toujours impeccablement justes (ouh le vilain tricheur), pas de problème, mais assurez-vous de disposer d'un micro convenable et d'éviter les bruits de fond. Si votre enregistrement contient du souffle ou de l'écho, il vaudra mieux nettoyer l'enregistrement avant de s'en servir, avec un logiciel comme Adobe Audition ou avec un service de nettoyage audio par IA comme Audo Studio dont on parlait ici.

Au minimum, il vous faut une vingtaine de minutes pour obtenir un résultat vaguement convaincant. Mais le mieux est de dépasser la demi-heure et plus vous vous approchez d'une heure, mieux c'est. Il n'y a pas beaucoup d'intérêt à dépasser une heure de son, le progrès étant alors négligeable. Par ailleurs, la diversité sera importante aussi : mieux vaut 20 minutes de voix avec des intonations variées et une tessiture large, que 50 minutes sur un même ton monocorde.

L'enregistrement peut être réparti sur un ou plusieurs fichiers. La seule limite est de ne pas lui confier de fichiers de moins de 4 secondes.

Ce ou ces fichiers devront être enregistrés au format .wav et placés, seuls, dans un répertoire de votre choix. Retenez bien l'endroit où vous l'avez placé, vous allez en avoir besoin plus tard.

Et d'autres trucs

- Un acapella sur lequel appliquer le modèle : lorsque vous aurez votre modèle, vous ne pourrez pas l'appliquer directement à une chanson mixée. Vous devrez l'appliquer sur un acapella. Là encore, vous avez dans d'autres articles du site les moyens d'en produire. Vous pourrez ensuite mixer votre acappella modifié avec l'instrumentale créée pour avoir votre chanson définitive.

- Un PC relativement puissant : il est, comme souvent indispensable de disposer d'un GPU nvidia. Il est apparemment nécessaire qu'il s'agisse d'un GPU RTX pour effectuer l'entraînement. À défaut, vous pourrez appliquer un modèle déjà existant sur la chanson de votre choix, mais pas en créer un nouveau. Nous avons testé Applio sur une RTX 2060 Super et obtenu des résultats satisfaisants en quelques heures. Il faudra par ailleurs allouer suffisamment de VRAM et de RAM pendant l'entraînement... n'espérez pas jouer en même temps.

- Et bien sûr, télécharger et installer Applio (lien de téléchargement en bas de cet article).

Installer et lancer Applio.

Téléchargez le zip via le lien en fin d'article, décompressez l'archive (attention, c'est un gros bébé), puis rendez-vous dans le répertoire où les fichiers ont été décompressés et double-cliquez sur run-applio.bat.

Après quelques instants de chargement, une page web locale s'ouvre. Alors avant de commencer quoi que ce soit de sérieux, vous allez tout de suite me faire un plaisir.

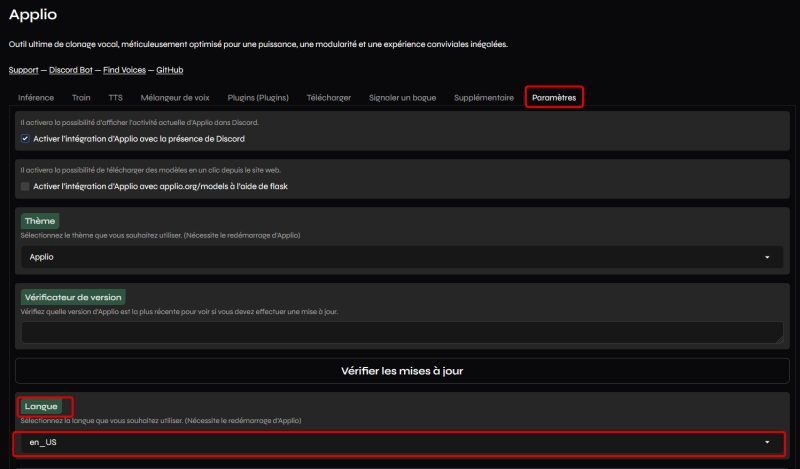

Vous allez vous rendre dans l'onglet Paramètres, puis dans la section Langue et passer sur en_US (c'est-à-dire Anglais), la langue dans laquelle le logiciel a été écrit.

Je sais, je sais. Tout le monde n'est pas à l'aise en anglais, mais l'IA ne sert manifestement pas qu'à faire des covers... elle a aussi manifestement servi à traduire l'interface et le moins que l'on puisse dire est que le résultat est loin d'être convaincaint. "Hops" a ainsi été traduit en "Houblons", "Autotune" devient "Réglage automatique" et "Pitch" devient tantôt "Hauteur", tantôt... "Tanguer". À ce niveau de n'importe quoi, il vaut mieux en rester à l'anglais. Cela permettra au passage d'utiliser le vocabulaire couramment utilisé dans le moteur de l'IA ("Epoch" plutôt que "Époque" par exemple), ce qui vous facilitera les recherches Google si vous rencontrez un problème à un moment ou un autre.

Donc, passer à l'anglais, redémarrez Applio, puis rendez-vous dans l'onglet "Train".

Entraîner un nouveau modèle

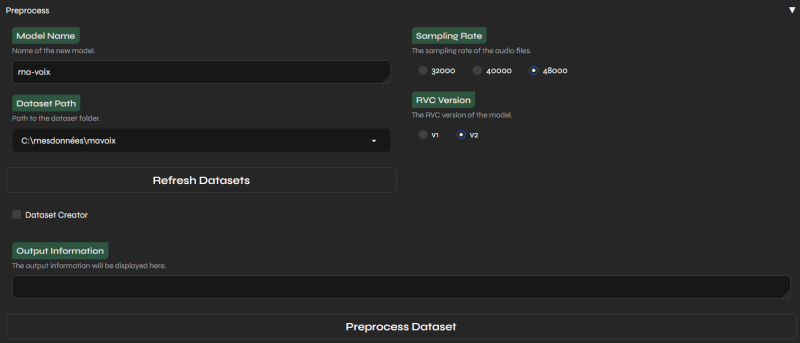

C'est là que vous allez avoir besoin du jeu de données dont on avait parlé en début d'article : il vous faut au moins 20 minutes de voix impeccablement isolée de tout autre son parasite (souffle, autre voix, instruments, voitures qui passent...), sous forme de fichier(s) .wav (48000 Hz recommandé), placés dans un dossier.

Model name : Ici, entrez le nom que vous voulez donner à votre modèle. "Ma voix", "François Hollande", "Michael Jackson", peu importe.

Dataset path : Le répertoire dans lequel vous avez mis les fichiers audio de la voix à imiter. Par exemple C:\mesdonnées\mavoix

Sampling rate : le taux d'échantillonnage de la voix. Plus vous choisissez un taux d'échantillonnage élevé, meilleure sera la qualité. Donc tant qu'à faire, autant passer à 48 000.

RVC Version : la version 2, sans hésiter.

Puis, vous pouvez cliquer sur Preprocess dataset. À ce stade, vous n'entraînez pas encore votre modèle, vous préparez juste les données pour qu'elles soient utilisables pour l'entraînement. Si vous avez tout bien fait comme il faut, vous devriez voir une barre de progression et un traitement qui va durer quelques secondes à quelques dizaines de secondes.

Si l'interface vous renvoie une erreur, ou si quelque chose semble anormal (par exemple le traitement semble instantané), il peut être utile de jeter un œil à la fenêtre de ligne de commande qui s'est ouverte au lancement d'Applio pour voir ce qui se passe. L'interface web a en effet une fâcheuse tendance à ne pas donner de détails, voire à ne pas vous prévenir du tout en cas d'erreur. Vérifiez notamment que vous lui avez donné le bon répertoire où trouver les données.

Si tout s'est bien passé, vous pouvez passer à l'étape suivante, l'extraction des données.

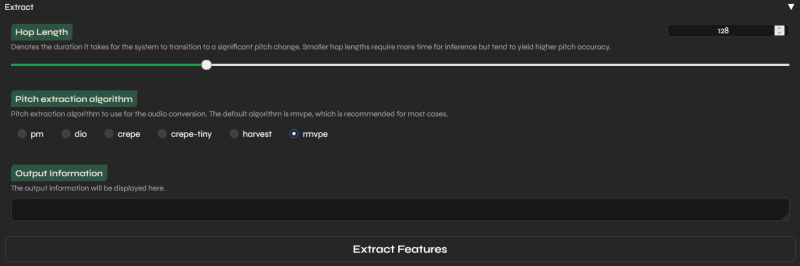

Là encore, quelques réglages à déterminer avant de se lancer, même si les réglages par défaut peuvent faire l'affaire.

Hop Length (et non pas longueur du houblon) : Un chiffre plus bas permet plus de finesse dans la gestion du pitch, c'est-à-dire de la hauteur des notes, ce qui peut être utile surtout en matière de chant en permettant un chant plus juste et un modèle moins robotique, moins "excès d'autotune". En revanche, cela augmente significativement le temps de traitement. Le niveau de qualité par défaut, 128, est satisfaisant. Ne montez pas au-dessus au risque sinon d'avoir une voix qui chante "faux". Vous pouvez descendre en dessous, jusqu'à 64, pour un peu plus de précision... la différence sera souvent subtile mais parfois suffisante pour faire une petite différence. Inutile de descendre en dessous de 64, la différence devient alors négligeable et ce serait une perte de temps et de puissance de calcul.

Pitch extraction algorithm : Le choix par défaut, rmvpe, est adapté à la plupart des cas, discours et chant. Cependant, parfois, il peut être intéressant d'essayer l'algorithme harvest ou crepe pour des résultats légèrement différents. Crepe est notamment réputé un peu plus à l'aise sur les variations subtiles de ton, notamment en cas de chant usant énormément de glissandos.

Plus qu'à cliquer sur Extract features et à patienter quelques dizaines de secondes à quelques minutes (notamment selon la Hop length choisie) pour extraire les aspects fondamentales de la voix. À ce stade, vous n'avez pas encore entraîné le modèle, mais vous avez extrait toutes les informations dont il a besoin pour travailler.

On peut donc passer à la dernière partie :

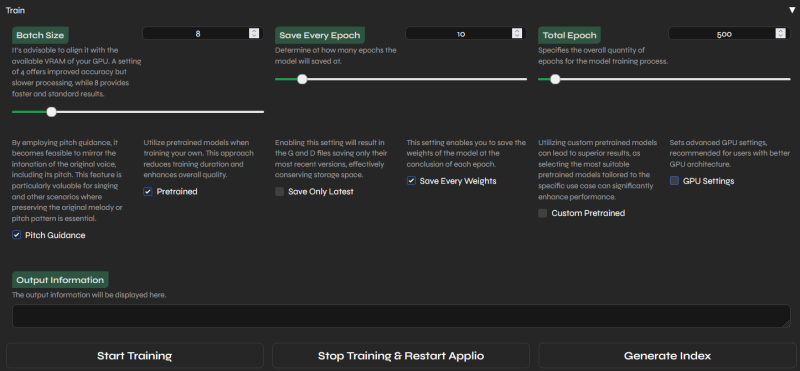

Vous l'aurez tout de suite remarqué, cette dernière étape est un peu plus velue. Pas mal de réglages, mais là encore les réglages par défaut ne sont pas mauvais, même si un dernier affinage sera sans doute bienvenue. Passons-les donc en revue :

Batch size : Il s'agit de la quantité de données traitées simultanément. La valeur par défaut est généralement un bon compromis, vous pouvez essayer de l'augmenter légèrement pour accélérer la vitesse de traitement, ou de la réduire si vous recevez des erreurs de type "Cuda: Out of Memory". Mais ne vous éloignez jamais trop de la valeur par défaut, qui est choisie automatiquement par Applio en fonction de votre GPU et représente généralement le "juste milieu".

Save Every Epoch : Les "epoch" peuvent se concevoir comme des générations de modèle. Les premières générations sont parfaitement incompétentes et le modèle s'améliore epoch après epoch... or, il n'est pas souhaitable de ne garder que la dernière epoch. D'abord parce qu'en cas de plantage avant la fin, ce serait dommage de tout perdre. Ensuite parce qu'il arrive un stade où le modèle ne s'améliore plus vraiment, il peut même commencer à régresser. Sauvegarder régulièrement les epochs est donc doublement utile. Mais sauvegarder toutes les epochs serait carrément excessif, la différence entre deux epochs étant généralement très faible. Même la valeur par défaut de 10 est sans doute excessivement prudente. Une sauvegarde toutes les 20 ou 25 epochs fera sans doute parfaitement l'affaire, tout en vous faisant économiser quelques gigas d'espace disque.

Total Epoch : il s'agit de la dernière epoch d'entraînement du modèle. L'entraînement s'arrêtera automatiquement après. On trouve sur Internet des opinions très variables sur le nombre d'epochs qui méritent d'être calculées. Attention, certaines personnes ont de vieux réflexes basés sur d'autres technologies plus anciennes... En pratique pour RVC2/Applio, on conseille typiquement 200-250 epochs pour avoir quelque chose de valable. Mais aller plus loin peut apporter un gain supplémentaire. En pratique, 500 epochs, la valeur par défaut, est sans doute trop. 400 est généralement largement suffisant et laisse même un peu de marge.

Pitch Guidance : il est généralement souhaitable de garder cette case cochée. Les modèles "pitchless", bien qu'un peu plus légers, sont moins précis et moins à l'aise dans certaines tâches comme le chant, sans avoir de défaut particulier (si ce n'est le fait d'être un peu plus gourmands).

Pretrained : là encore, mieux vaut laisser cela coché. "Pretrained" signifie qu'Applio va charger un modèle généraliste pré-entraîné et ensuite, commencer à affiner ce modèle avec les données que vous lui avez fourni. En général, ce mode de fonctionnement est largement préférable et permet d'obtenir une meilleure qualité, plus rapidement.

Save Only Latest : vous pouvez cocher cette fonctionnalité si vous avez besoin de sauvegarder de l'espace disque, mais ce n'est pas indispensable.

Save Every Weights : il est conseillé de cocher cette case, utile notamment si vous envisagez d'essayer votre modèle à des stades intermédiaires, pendant que votre GPU est encore en train de mouliner de nouvelles epochs.

Custom Pretrained : si vous avez des modèles pré-entrainés que vous souhaitez utiliser comme base et dont cet entraînement ne constituera qu'un affinage, c'est ici que ça se joue. Sinon, si vous partez de zéro ou d'un simple modèle généraliste fourni avec Applio, laisser la case décochée. Dans la plupart des cas, vous ne cocherez donc pas cette case.

GPU Settings : si vous avez plusieurs cartes graphiques sur votre PC (par exemple, un GPU Intel intégré au CPU + une carte distincte nvidia), cochez cette case et entrez le numéro de GPU souhaité (vous verrez s'afficher une liste des GPU détectés avec un numéro, généralement 0 pour le GPU par défaut, 1 pour le suivant, etc.) Sinon laissez la case décochée pour utiliser la valeur par défaut, qui sera toujours la bonne dans les configurations mono-GPU.

Voilà, les réglages sont prêts. Vous pouvez à présent cliquer sur Generate Index pour générer un index (cela vous permettra de tester votre modèle à des stades intermédiaires). Puis, une fois que l'index est généré, cliquez sur Start Training.

Si tout se passe bien, votre GPU va alors commencer à mouliner, l'entraînement démarre... comptez quelques dizaines de minutes à quelques heures en fonction de la puissance de votre GPU, du nombre d'epochs, des différents réglages... À titre d'exemple, avec 21 minutes d'audio, une RTX 2060 Super et des réglages de base, il nous a fallu environ 2h40 pour obtenir un modèle correct. Le modèle a tourné plus longtemps que ça (près de 4 heures) mais les epochs obtenus après cette limite n'ont pas apporté d'amélioration.

Si à un moment donné l'entraînement plante avant la fin pour une raison quelconque, pas de panique : il suffit de relancer l'entraînement. Il suffit de redonner le même nom de projet et de ne surtout pas refaire les parties 1 et 2. Relancez directement l'entraînement et cela devrait reprendre à peu près où ça s'était arrêté.

Sinon, si l'entraînement a été au bout, super ! Vous avez désormais un modèle prêt à être utilisé !

Utiliser le modèle pour changer la voix d'une chanson

Vous avez votre modèle ? Bien ! Comme vu dans les prérequis, il vous faut aussi une chanson en version acappella. Si ce n'est déjà fait, il vous faut donc séparer la voix et la musique du morceau choisi. Attention, le modèle ne fonctionne pas non plus si plusieurs voix chantent en chœur, car cela perturbe complètement la détection des notes. Il faut donc un chanteur ou une chanteuse solo.

Vous avez tout ce qu'il vous faut ? Rendez-vous alors dans l'onglet Inference.

À ce stade, une remarque s'imposer : l'inférence, c'est-à-dire le fait de plaquer un modèle et donc une nouvelle voix sur une source audio, peut être faite avec n'importe quel type de GPU, pour le coup pas besoin de GPU nvidia. Mais bien-sûr, cela n'est possible que si l'on vous a fourni un modèle prêt à être utilisé. On en trouve un certain nombre sur Internet.

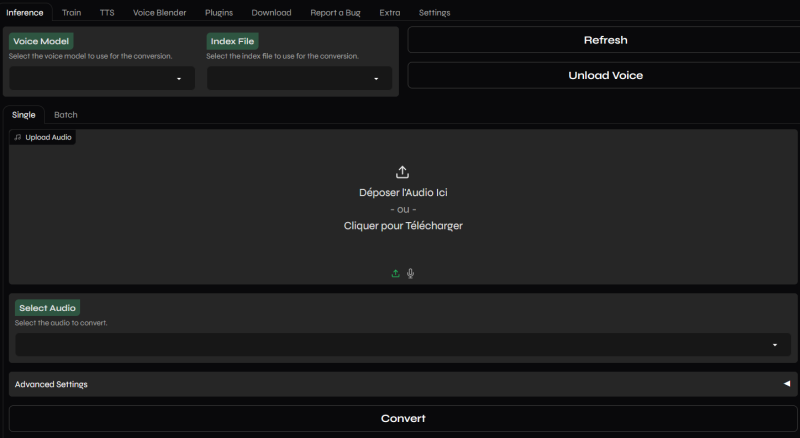

Vous arrivez alors sur l'interface suivante :

Là encore, prenons le temps de décortiquer ce qu'il y a à voir ici.

En principe, vos modèles (à différentes epochs) sauvegardés ainsi que le fichier d'index correspondants sont disponibles dans les listes déroulantes Voice Model et Index File.

Vous devriez avoir un seul fichier d'index par modèle, mais sans doute plusieurs "Voice model" correspondant aux différentes epochs sauvegardées.

Choisissez vos modèles, puis, dans la section Upload audio, placez le fichier acappella à transformer.

Le fichier est automatiquement converti si besoin et apparaît dans la case Select Audio.

À ce stade, vous pourriez lancer la conversion immédiatement, mais il est amplement préférable de passer par la section Advanced Settings, car plusieurs réglages peuvent être nécessaires pour obtenir un bon résultat. Cliquez sur la case pour dérouler un menu plein de paramètres avancés, ressemblant à ceci :

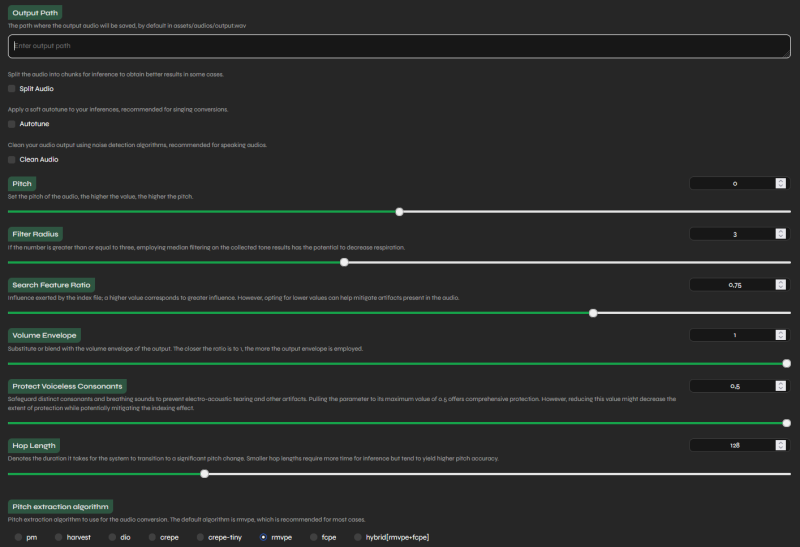

Output path : permet de choisir l'endroit où enregistrer le résultat final.

Split audio : sépare l'audio en morceaux pour faciliter le travail de RVC. Cela peut apporter un petit gain de qualité dans certains cas. Cela n'a pas tellement d'effets négatifs, à part celui de consommer un peu plus de VRAM. Si vous êtes limite et que vous recevez des erreurs "CUDA: Out of Memory error", essayez de désactiver cette option. Sinon, il est préférable de la laisser activée.

Autotune : applique un léger autotune sur le chant pour aider le chant à être "plus juste", car le plaquage d'une autre voix a tendance à faire ressortir les fausses notes. En pratique, la différence est vraiment subtile, mais c'est sans doute une bonne idée de le cocher en cas de chant (et pas du tout en cas de discours).

Clean audio : ne devrait pas être nécessaire si votre modèle d'origine est vraiment clean, sinon, cela peut faire disparaître un peu le souffle, la réverbération et d'autres défauts, surtout en cas de discours. Peu utile en musique d'autant que les instruments vont "noyer" le souffle et que la réverbération peut être un effet recherché.

Pitch : permet de modifier la hauteur globale de la chanson. En général, il est préférable de garder cette valeur à 0 pour garder le pitch d'origine, mais il peut être nécessaire de modifier le pitch si la tessiture de votre modèle est inadaptée. C'est-à-dire que si la voix que vous avez clonée est trop grave, ou trop aigüe, pour la chanson que vous voulez lui faire chanter, adapter le pitch peut permettre de rattraper ce souci.

Filter radius : il n'est généralement pas conseillé de toucher à cette valeur, qui vise à modifier l'effet de respiration de l'audio.

Search feature ratio : plus vous rapprochez cette valeur de 1, plus le nouveau fichier audio se rapproche en tous points des caractéristiques de la voix clonée, mais plus vous risquez d'avoir d'artefacts désagréables. Plus vous réduisez cette valeur, plus le résultat final conserve certaines caractéristiques de la voix d'origine, mais cela peut réduire un peu les artefacts. Généralement, la valeur par défaut est un bon compromis. Mais vous pouvez expérimenter par vous-même au cas par cas.

Volume enveloppe : plus la valeur est proche de 1, plus le son final respecte le volume du fichier d'origine à chaque instant. Plus vous la diminuez, plus le modèle prends de liberté avec le volume. Il est généralement recommandé de laisser cette valeur à 1.

Protect voiceless consonant : il s'agit de préserver les consonnes sourdes, ce qui peut éviter certains artefacts. Là encore, mieux vaut laisser le réglage par défaut, qui offre une préservation maximale et réduit certains artefacts.

Hop Length : comme pour l'entraînement, il s'agit du niveau de précision avec lequel se fera la détection de la hauteur des notes à chaque instant. Si vous fixez une valeur trop haute, votre fichier final ne chantera parfois pas les bonnes notes. La valeur de 128 par défaut est généralement suffisante. Vous pouvez réduire un peu, sans descendre plus bas que 64 (en dessous de 64, aucun gain n'est à espérer), mais sachez que le gain est faible et que plus vous réduisez cette valeur, plus le traitement prendra de temps.

Pitch extraction algorithm : comme pour l'entraînement, choisissez rmvpe pour la plupart des situations, et essayez crepe si vous avez un chant avec beaucoup de glissando, c'est-à-dire que le chanteur fait monter et descendre la note. La différence est subtile mais il semble que crepe parvienne légèrement mieux à reproduire les variations fines de pitch.

Voilà, plus qu'à cliquer sur Convert et à patienter quelques secondes à quelques minutes... En bas s'affichera un message confirmant la bonne réussite de l'inférence, et la possibilité d'écouter votre résultat directement depuis l'interface. Si le résultat ne vous convient pas, n'hésitez pas à itérer avec d'autres réglages avant de partir du principe que votre modèle est raté.

Une erreur qui peut survenir après la conversion, est que la hauteur de la chanson finale est complètement buguée. Si vous constatez que le chant est 10x trop grave, style "bande qui tourne au ralenti", vérifiez dans la fenêtre de terminal que vous n'avez pas d'erreur de type "CUDA: Out of Memory Error" ou autre. Si c'est le cas, essayez de redémarrer Applio, ou de fermer des logiciels susceptibles d'occuper de la RAM et de la VRAM. Puis relancez l'inférence.

N'oubliez pas non plus que vous ne pouvez pas faire chanter n'importe quoi à n'importe qui : un modèle ne fonctionne que sur une tessiture (c'est-à-dire une gamme de notes) donnée, déterminée par ses données d'entraînement. Si votre modèle a été entraîné sur une voix qui ne parle/chante jamais plus aigu que Barry White, vous ne lui ferez pas chanter proprement du Michael Jackson et vice-versa. De même, si votre modèle est entraîné uniquement sur du français, il risque d'avoir du mal avec certaines consonnes anglaises qui n'existent pas chez nous. Enfin, rappelons que RVC2 fonctionne très mal sur des chants en chœur, ou même simplement deux lignes de chant en même temps : cela ruine la détection du pitch et même la détection des consonnes, et peut donc donner lieu à une bouillie peu convaincante.

Néanmoins, avec un peu d'ingéniosité, on arrive à des choses surprenantes. Jugez plutôt ce que nous avons fait chanter au président Macron :

Le résultat vous semble convaincant ? Tant mieux ! Mais pour arriver à ce résultat convaincant, nous avons respecté les différents conseils prodigués ici. Voici quelques exemples "d'accidents" qui peuvent arriver si vous ne respectez pas ces conseils :

Erreur n°1 : Ne pas respecter la tessiture du modèle

Si vous faites chanter au modèle quelque chose de beaucoup trop aigu (ou beaucoup trop grave) par rapport à la voix naturelle que vous avez clonée, le résultat sonnera robotique et désagréable. Très audible ici dans cet extrait de We are the world.

Erreur n°2 : Pas assez d'epochs

Si vous n'entraînez pas suffisamment votre modèle, la voix ne sera pas vraiment fidèle à celle que vous essayez de reproduire, possiblement robotique, ou très générique. Audible ici en reprenant l'extrait des P'tites femmes de Pigalle.

Erreur n°3 : Un modèle entraîné sur une langue et plaqué sur une autre

Que se passe-t-il si l'on entraîne un modèle uniquement sur du français et qu'on lui fait chanter de l'anglais ? La plupart du temps, rien de particulier. Les deux langues ont suffisamment de phonèmes en commun pour que ça se passe pas trop mal. Mais parfois, l'IA se met à galérer. Exemple ici avec un deuxième extrait de We are the world. Les paroles de cet extrait sont censées être :

There are people dying

Oh, it's time to lend a hand

To life

Mais à la place, on a plus droit à quelque chose comme :

They are peepkee dying

Oh, it's time to lend a rrrhhhand

To limpfe

Écoutez plutôt :

Erreur n°4 : plusieurs voix en même temps.

Prenons un grand monument de la chanson française, La fête au village des Musclés. Le refrain est chanté en chœur... le moins que l'on puisse dire est que RVC est complètement largué. Il n'a ni la mélodie, ni les paroles ! Pour le coup, on a l'impression qu'il a effectivement bien fait la fête, notre modèle... sans doute trop. Jugez-en :

Les chœurs représentent un cas extrême, mais même simplement deux voix simultanées (même deux voix du même chanteur, via ce qu'on appelle un overdub) suffisent généralement à perturber le modèle.

Erreur n°5 : hop length incorrecte ou pitch detection algorithm inapproprié

Ces deux paramètres sont ce qui va permettre au moteur de détecter correctement la hauteur des notes sur lesquelles plaquer le modèle. Si ces paramètres sont mal configurés, des résultats étranges peuvent en sortir. Exemple ici avec un extrait de Mistral Gagnant, de Renaud. D'abord avec des paramètres corrects (algo rmvpe et hop length de 64) puis avec des paramètres inappropriés pour cet usage (algo crepe et surtout, plus gros problème, hop length de 512).

Clairement, il y en a un plus correct que l'autre. Attention, certains algorithmes sont plus sensibles que d'autres à un hop length incorrect. Ainsi, par exemple, crepe est vraiment plus à l'aise avec des hop length faibles, tandis que harvest s'accomode assez bien de hop lengths élevés.

Erreur 6 : ne pas fournir de version acappella au modèle

Clairement, la plus grosse erreur que vous puissiez faire, c'est fournir une chanson complète, avec son instru, au modèle, au lieu de commencer par isoler la voix avec UVR5 ou MVSEP.

Exemple ici avec un extrait de L'Homme pressé de Noir Désir... écoutez d'abord le premier extrait : ici, nous avons correctement isolé la version acappella depuis le site de MVSEP et fourni ça au modèle : le texte est clair, compréhensible, exploitable, pas de souci majeur.

Mais que se passe-t-il si on prend un raccourci, qu'on zappe la séparation de sources et qu'on lui file directement la chanson complète à analyser ? Eh bien, essayons avec exactement le même extrait, mais sans isoler la voix : le texte devient une bouillie incompréhensible, l'air n'est plus juste, et en plus, le modèle tente de chanter les guitares en même temps et de faire un genre de beatbox de la batterie... le résultat est parfaitement inexploitable. Jugez par vous-même :

Voilà les six grandes erreurs que vous êtes le plus susceptible de rencontrer.

Mais si vous évitez tous les écueils et que vous suivez attentivement les instructions de cet article, vous pouvez arriver à des choses sympathiques. Évidemment, une fois votre acappella transformé, il faudra encore lui rajouter son instrumentale avec un logiciel de mixage audio (Audacity fera parfaitement l'affaire). On se met un dernier extrait pour la bonne bouche :